Alexa, ich bin traurig! Wie gut gehen Sprachassistenten damit um?

Timer stellen, Nachrichten vorlesen, Wetterbericht ansagen – das können Chatbots und intelligente persönliche Assistenten vermutlich ähnlich gut wie wir selbst bzw. unsere Mitmenschen. Aber wie gut gehen Sprachassistenten mit der Aussage „Ich bin traurig!“ um? Wie gut sind die Antworten der Assistenten? Und sind die Antworten von Alexa besser als Siris?

Diesen Fragen gingen wir im Rahmen einer Kooperationsstudie mit der Hochschule Döpfer nach.

Methodischer Rahmen

Hier ein kurzer Überblick über die relevanten methodischen Eckdaten. Die Studie wurde als Online Umfrage unter Studierenden der Hochschule realisiert:

- Stichprobengröße: N = 49

- Alter: zwischen 18 und 41 Jahre alt

- Geschlecht: 30w, 19m

Die Teilnehmer waren überwiegend Unerfahren hinsichtlich der Nutzung von Sprachassistenten. 76 % gaben an, keine Sprachassistenten zu nutzen. 14 % nutzen einen Sprachassistenten von Google, 8 % Siri und 1 Teilnehmer (entspricht 2 %) nutzt Alexa.

Aussagen

Den Teilnehmern wurden verschiedene Antworten auf die Aussage:

-

„Ich bin traurig“

visuell, bzw. schriftlich präsentiert.

Dabei wurden drei Antworten neu generiert (also von der Quelle Mensch), zwei Antworten von Amazons Alexa und drei Antworten von Apples Siri herangezogen. Folgende Aussagen wurden untersucht:

A1 (Mensch): Was ist los? Wie kann ich dir helfen?

A2 (Mensch): Willst du darüber reden?

A3 (Mensch): Oh nein, das tut mir leid für dich!

A4 (Alexa): Es tut mir leid, dass du dich so fühlst. Manchmal kann es helfen mit einem Freund zu sprechen, Musik zu hören oder auch mal einen Spaziergang zu unternehmen. Ich hoffe es geht dir bald besser!

A5 (Alexa): Es tut mir wirklich leid, dass du dich so schlecht fühlst. Denk daran, dass du damit nicht alleine bist, es gibt Leute die dir helfen können. Du könntest mit einem Freund oder einem Arzt sprechen. Du kannst dich auch unter 0800 1110111 an die deutsche Telefonseelsorge wenden.

A6 (Siri): Bei diesem Gefühl hilft nur eins: Schokolade!

A7 (Siri): Aus der Traurigkeit wächst die Kraft!

A8 (Siri): Wenn ich es richtig verstehe gehört das Traurigsein genau wie das Glücklichsein zum Leben dazu.

Vorgehensweise, Messinstrument

Die Aussagen sollten hinsichtlich 3 Dimensionen bewertet werden: Nützlichkeit, Motivationsausmaß und Zufriedenheit. Außerdem sollten die Probanden beurteilen, von welcher Quelle (Mensch vs. Chatbot) die Aussagen stammen. Die Probanden bekamen die Aussagen in randomisierte Reihenfolge dargeboten. Für jede Aussage wurden unter anderen die folgenden vier Fragen beantwortet:

- 1. Von wem stammt diese Antwort? (= Quelle)

(single-choice Chatbot vs. Mensch)

- 2. Für wie hilfreich halten Sie diese Antwort? (= Nützlichkeit)

(Skala von 0 = gar nicht bis 3 = hilfreich)

- 3. Wie motiviert sind Sie das Gespräch weiter zu führen? (= Motivationsausmaß)

(Skala von 0 = gar nicht bis 3 = motiviert)

- 4. Wie zufrieden sind Sie mit der Antwort? (= Zufriedenheit)

(Skala von 0 = gar nicht bis 3 = zufrieden)

Ergebnisse

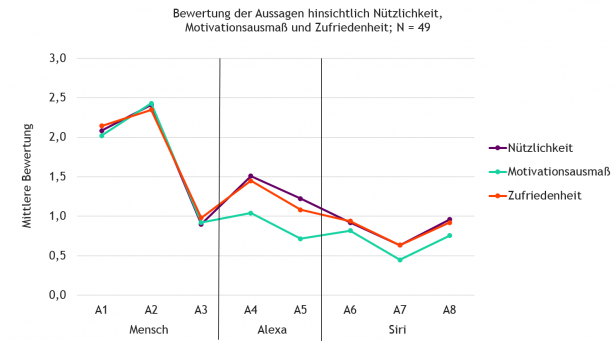

Zunächst interessiert Sie vielleicht, welcher Sprachassistent nun besser mit der Aussage „Ich bin traurig!“ umgeht und ob vielleicht die Antwort eines Sprachassistenten mit einer vom Menschen vergleichbar gut ist. Keine Sorge, die zwei mit Abstand am höchsten bewerteten Antworten auf allen drei Skalen sind von einem Menschen, nämlich A2: „Willst du darüber reden?“ und A1: „Was ist los? Wie kann ich dir helfen?“. Die Bewertung der weiteren Aussagen können Sie dem folgenden Diagramm entnehmen. So viel noch vorweg: Alexa hat augenscheinlich etwas besser abgeschnitten.

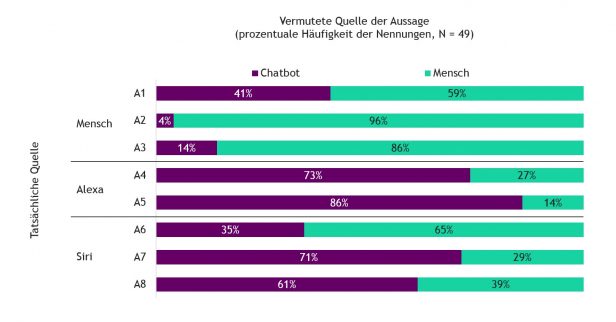

Nun zu der Frage: Wie gut konnten die Probanden die Antworten der richtigen Quelle zuordnen? Sind Aussagen eines Chatbots so „künstlich“, dass diese eindeutig als solche erkannt werden, wenn sie NICHT über eine blecherne Stimme gehört werden, sondern gelesen werden?

Nein.

Das folgende Diagramm zeigt die Daten. Bei der Interpretation dieser Daten halten Sie bitte folgendes im Hinterkopf: Die Rate-Wahrscheinlichkeit bei dieser Frage lag bei 50 %. Würden alle Teilnehmer die Frage rein zufällig beantworten (weil Sie z. B. keine Einschätzung über die Quelle treffen können), dann käme ein Wert von 50 % pro Quelle heraus. Wird also eine Aussage von 50 % der Teilnehmer der richtigen Quelle zugeordnet, ist dies ein ziemlich schlechtes Ergebnis!

Was zeigt uns dann dieses Bild? Die Zuordnung der Aussagen zur korrekten Quelle misslingt meist! Zum Beispiel Aussage A6 von Siri „Bei diesem Gefühl hilft nur eins: Schokolade!“ wird sogar häufiger einem Menschen zugeordnet als einem Chatbot. Oder Aussage A1 eines Menschen: „Was ist los? Wie kann ich dir helfen?“ wird von 41 % der Teilnehmer der Quelle Chatbot zugeordnet.

Übergreifend zeigt sich, dass die Aussagen von Alexa tendenziell eher einem Chatbot zugeordnet werden als die Aussagen von Siri.

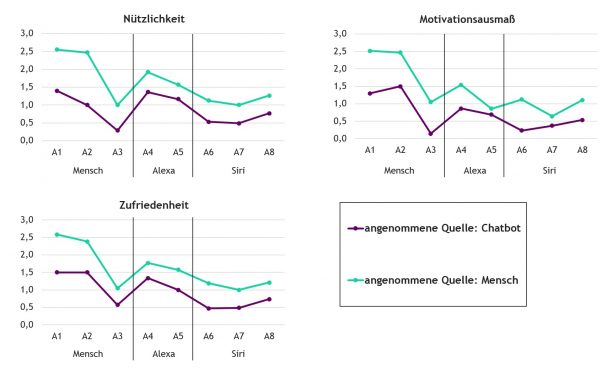

Was bedeuten dann die Ergebnisse zur Einschätzung der Nützlichkeit, Zufriedenheit, etc. vor dem Hintergrund dieser Erkenntnisse? Das ist das wirklich spannende dieser Studie!

- Die Einschätzung der Güte (Nützlichkeit, Motivationsausmaß, Zufriedenheit) einer Antwort hängt nicht nur von der Aussage an sich ab!

Wir haben die Ergebnisse nochmal detaillierter analysiert. Dabei zeigt sich, dass die Bewertung der drei Variablen Nützlichkeit, Motivationsausmaß und Zufriedenheit mit einer Antwort davon abhängig ist, welcher Quelle die jeweilige Aussage zugeschrieben wird. Und zwar unabhängig davon, ob diese Zuschreibung korrekt oder falsch ist.

Einfacher ausgedrückt: Wenn ein Nutzer glaubt/denkt eine Aussage stammt von einem Menschen, wir diese besser bewertet. Wenn ein Nutzer glaubt/denkt, dass eine Aussage von einem Chatbot stammt, wird diese schlechter bewertet – unabhängig von der Aussage an sich. Die folgende Abbildung zeigt die Daten.

Sie sehen beispielsweise anhand der Aussagen A1 und A4 was das bedeuten kann:

Eine menschliche Aussage A1 wird – wenn sie fälschlicherweise einem Chatbot zugeordnet wird – schlechter bewertet (in allen 3 Dimensionen) als eine Alexa-Aussage A4, wenn diese fälschlicherweise einem Menschen zugeordnet wird.

Fazit

Die Reaktion der Sprachassistenten auf die Aussage „Ich bin traurig?“ ist hinsichtlich der User Experience sicher nicht kriegsentscheidend. Und ob nun Siri oder Alexa besser darauf reagiert auch nicht – ich glaube die Technik ist heute noch nicht so weit, dass sich jemand ernsthaft mit seinem Sprachassistenten über seine emotionale Verfassung austauschen möchte.

Dennoch kann man aus den Studienergebnissen interessante Folgerungen für die Entwicklung von Skills oder sonstigen Anwendungen mit einem VUI ableiten.

VUI-Antworten lassen sich offensichtlich so gestalten, dass sie – wenn sie über ein anderes Medium dargeboten werden (in diesem Fall: schriftlich) – nicht eindeutig als solche identifiziert werden können. Dies ist relevant, denn allein der durch den Nutzer eingeschätzte Ursprung einer Antwort beeinflusst deren wahrgenommene Nützlichkeit, Motivation und Zufriedenheit.

Haben Sir noch Fragen oder Ergänzungen, dann kommentieren Sie gerne!

Abschließend noch der Dank an die durchführenden Studierenden der Hochschule Döpfer: Julia Schlegel, Joeanne Liese, Katharina Otto, Simon Busch und Max Sebus.

Abschließend noch der Dank an die durchführenden Studierenden der Hochschule Döpfer: Julia Schlegel, Joeanne Liese, Katharina Otto, Simon Busch und Max Sebus.

Für mich zeigen diese Ergebnisse vor allem, dass die menschliche Kommunikation über Gefühle keine „praktischen Tipps“ oder „Antworten“ erwartet, sondern eben erstmal „nur“ Mitgefühl und Zuhören, während hier die Chatbots gleich ungefragte standardisíerte allgemeine Phrasentipps geben. Das war sicher der „Fehler 😉