Die Zukunft der Sprachassistenten – entscheidet sie sich 2018?

2017 war das Jahr der Sprachassistenten. Wir haben viele Experimente gesehen – beziehungsweise gehört –, viele spannende neue Ansätze und natürlich auch Vieles, was nicht funktioniert hat. Geht das auch dieses Jahr so weiter? Ich denke schon.

Und auch wer selbst gar keine eigene Sprachsteuerung oder virtuelle Assistenten entwicklen will – auseinandersetzen müssen wir alle uns mit dem Thema. Denn es hat das Potenzial, die Art und Weise wie Menschen mit Maschinen umgehen, grundsätzlich zu verändern. Mehr noch, als es die Smartphone-Revolution getan hat.

Wie bei allen großen Veränderungen wird es dabei Gewinner und Verlierer geben. Firmen, die derzeit ganz vorn mitspielen, finden sich in ein paar Jahren vielleicht dort wieder, wo Nokia nach der Smartphone-Revolution gelandet ist.

Aber auch wer nur eine kleine Website betreibt, für den könnten sich gravierende Änderungen ergeben. Denn wenn wir zum Beispiel in Zukunft nicht mehr selbst suchen im Internet, sondern das ein virtueller Assistent für uns macht, wird sich die ganze Branche radikal ändern. Suchmaschinenoptimierung etwa wird völlig anders aussehen als heute. Und Online-Werbung sowieso.

Wer gewinnt?

Durchsetzen wird sich letztlich natürlich das, was die meisten Nutzer kaufen bzw. verwenden. Knackpunkt dabei ist die Bequemlichkeit (Convenience): Wenn die Assistenten so weit sind, dass sie gute und zuverlässige Ergebnisse liefern, dann macht sich bald niemand mehr die Mühe, selbst im Browser eine Suchanfrage zu starten und die Trefferliste zu begutachten.

So wie wir heute praktisch nie mehr auf die zweite Seite der Suchmaschinenergebnisse gehen, weil praktisch immer einer der ersten vier Treffer zumindest gut genug ist.

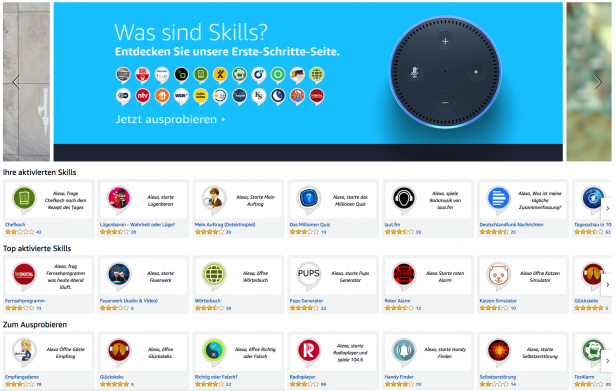

Der App-Hype ist vorbei – der Skill-Hype auch?

Skills waren im letzten Jahr definitiv ein riesen Thema. Viele Marken wollten mit dabei sein. Und viele Marketer wollten sich den vermeintlich heißesten Trend nicht entgehen lassen. Und viele UX-Designer und Programmierer wollten einfach mal was Neues ausprobieren.

Aber hat es sich ausgezahlt?

Klar, Erfahrung hat man in jedem Fall gewonnen. Aber hat es der Marke, dem Unternehmen etwas gebracht? Die Antwort muss natürlich jeder selbst für sich finden – aber nach meinen Gesprächen mit Kollegen und nach dem, wie der „Skill-Store“ aussieht, ist die Antwort wohl in den meisten Fällen: nein.

Amazon Echo Skills haben aus meiner Sicht zwei große Probleme:

- Die Skills sind schwer zu entdecken und werden leicht vergessen.

- Die Marke ist kaum sichtbar zu machen und kaum zu kontrollieren.

Die Skills kann man zwar auch per Sprachsteuerung aktivieren, doch der Weg geht für die meisten immer noch über die Amazon-Website. Und verglichen damit sind die unübersichtlichen App Stores von Apple und Google ein Hort der Ordnung und Inspiration.

Aber selbst wenn der Skill gefunden und aktiviert ist – die Wahrscheinlichkeit ist, groß, dass er wieder vergessen wird. Es gibt nur wenige Untersuchungen dazu, die aber kamen zu Zahlen um die 3% Retention – das heißt, nach 2 Wochen nutzen 97% der Menschen den Skill nicht mehr. Bei Apps liegt der Wert um die 12%. Das Hauptproblem: An einen Skill muss ich mich erinnern, anders als bei einer App begegne ich im Alltag keinem Icon oder einer anderen Erinnerungshilfe.

Und: Bringt der Skill eine wirklich nützliche Funktion, besteht die Gefahr, dass Amazon beschließt, diese Funktion Alexa direkt beizubringen – der Skill wird nicht nur obsolet. Es kann zudem für die Nutzer sehr irritierend werden, weil für diese nicht immer klar ist, wer dann antwortet: der Skill oder die native Alexa-Funktion. Dann bleibt einem wenig übrig, außer den Skill aus dem Store zu nehmen.

Dabei mal ganz außen vorgelassen, dass es sehr schwer ist, einen guten Skill zu konzipieren – es gibt einfach wenig Anwendungsfälle, die mit den derzeitigen beschränkten Fähigkeiten der Spracherkennung (vor allem bei der Inhaltsanalyse) gut funktionieren.

Was derzeit in den Listen der am häufigsten aktivierten Skills auftaucht, gehört fast ausschließlich zu den folgenden Kategorien:

- Radio-Sender/Musik

- Nachrichten/Information

- Quiz/Unterhaltung

- Einkaufslisten/To-dos

Interessant wird es auch, wenn man sich ansieht, wer die Top-Skills umgesetzt hat. Hier finden sich kaum größere Marken. Vor allem unabhängige Programmierer und kleine Unternehmen sind weit vorn bei der Beliebtheit. Und das liegt nicht daran, dass es die großen Marken nicht versucht hätten. Sie konnten nur nichts auf die Beine stellen, was die Nutzer begeistert hätte.

Procter & Gamble, BMW, Mercedes Benz, Deutsche Bahn, Banken, Krankenkassen – von allen diesen Anbietern findet sich praktisch nie ein Skill auf den vorderen Plätzen. (Wobei man dazu sagen muss, dass die Kriterien unklar sind, nach denen Amazon die „Top-Skills“ sortiert. Amazon hat sicher mehr Interesse an SmartHome-Skills, denn die Produkte, die sich damit steuern lassen, verkauft das Unternehmen – Versicherungen oder Autos dagegen nicht.)

Die Anzahl der Skills in den jeweiligen Punktkategorien zeigt Amazon inzwischen übrigens nicht mehr an auf der Skill-Seite. Die Zahl der Ein-Sterne-Bewertungen war auf Dauer wohl doch zu peinlich.

Stirbt das GUI?

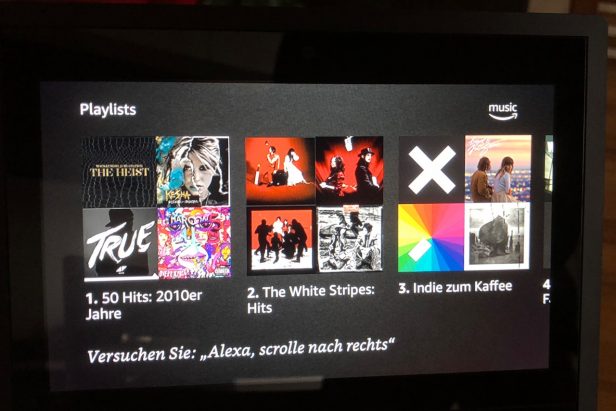

Die Grafische Benutzeroberfläche (GUI, für graphical user interface) wird auf absehbare Zeit nicht verschwinden. Im Gegenteil. Zu offensichtlich wurde bei Nutzertests von Alexa, Google Home und Kollegen, dass viele Dinge sich mit Hilfe eines Bildschirms doch viel, viel leichter regeln lassen als nur mit Sprachein- und -Ausgabe.

Und: Eine Pizza bestellt sich vielleicht bequemer per Sprache als per App. Aber würden wir eine Hose kaufen, ohne sie vorher gesehen zu haben?

Nachdem Amazon primär ein Shop ist, sind sie da natürlich dran. Seit einigen Wochen gibt es den Echo Show, einen Art Alexa-fähigen Mini-Fernseher im 80er-Jahre-Design.

Und in den USA gibt es seit ein paar Tagen zusätzlich den Echo Spot, eine Art Radiowecker mit Display im 70er-Jahre-Design.

Was mit dem Echo Show endlich gelöst ist, ist das konzeptionelle Problem, mit dem sehr, sehr viele Skills erfolglos gekämpft haben: Listen mit mehr als drei, vier Einträgen lassen sich mit Sprache kaum sinnvoll ausgeben und ein Eintrag daraus auswählen. Das gilt für Dinge wie Adressen oder Namen, noch mehr aber noch für Dinge mit wichtiger visueller Komponente wie Kinofilme oder die meisten Produkte.

Wir können schneller sprechen als tippen. Aber wir können komplexe Informationen viel schneller visuell erfassen als auditiv.

Das heißt, für die meisten Fälle ist es für uns Nutzer deutlich schneller, einem System Input per Sprache zu geben und den Output per Bild zu bekommen. Multimodale Interfaces werden wohl die Zukunft sein. Ob das wirklich alles ein Gerät sein wird, das wird sich zeigen. Generell stehen in den meisten Wohnungen und Büros schon mehrere Bildschirme, die Informationen anzeigen könnten. Da muss aber noch einiges an Zusammenarbeit bei den Herstellern passieren, bis das wirklich kommt. Technisch möglich wäre es problemlos schon heute.

Wann visuell, wann auditiv?

Zusammengefasst nochmal die Vorteile der jeweiligen Modi.

Die visuelle Ausgabe hat große Vorteile bei:

- längeren Listen

- Produkten, bei denen es auf visuelle Eigenschaften ankommt (Kleidung, Accessoires…)

- langen Texten, die nur teilweise gelesen rezipiert werden sollen (also meist informative Texte)

- größeren Datenmengen wie bei längeren zeitlichen Entwicklungen (wie Aktienkursen über längeren Zeitraum) oder komplexeren Zusammenhängen (wie Zusammenhang zwischen Alter und Reaktionsgeschwindigkeit)

- komplexen Daten (z.B. Darstellung von Landkarten)

- Vergleich von Produkten oder anderem

Die auditive Ausgabe ist im Vorteil bei:

- kurzen Informationen

- Warn- oder Status-Meldungen

- langen, linearen Texten, die dennoch ganz rezipiert werden sollen (also z.B. bei unterhaltenden Texten, Audiobooks etc.)

Und die auditive Eingabe hat vor allem Vorteile wenn:

- die Anweisungen kurz sind

- die Anweisungen leicht zu merken sind

- keine Nachfragen erforderlich sind (oder diese zumindest sehr einfach sind wie ja/nein)

- die Aufgabe nur auf eine Art und Weise sinnvoll erledigt werden kann (wie ein Timer gestellt wird, ist z.B. klar)

Für ein technisches System ist Sprache ein hervorragendes Eingabemedium – aber nur ein mittelmäßiges Ausgabemedium.

Der Kontext extrem wichtig: In manchen Situationen will ich nicht per Sprache steuern, z.B., wenn ich gerade im Zug sitze. Gerade dann will ich aber vielleicht gerade per Sprache Informationen aufnehmen (also z.B. einen Podcast hören).

Und wenn wir weiter in die Zukunft denken: Auch die nahtlose Interaktion der Geräte wäre ein großer Gewinn für die Nutzer (multimodal cross-device): z.B. will ich Infos über eine Busverbindung bei Alexa erfragen, während ich zu Hause meine Jacke anziehe. Dann brauche ich aber Infos zum Umsteigen unterwegs auf meinem Smartphone oder meiner Smartwatch. Bin ich im Büro angekommen, wäre es optimal, wenn mein PC dort weiß, dass ich den Text Korrektur lesen möchte, den ich auf dem Fußweg diktiert habe.

Wer macht das Rennen bei Digitalen Assistenten?

Amazons schnelle Folge der Vorstellung neuer Geräte zeigt: Sie wollen hier unbedingt den Fuß in die Tür bekommen – bzw. noch weiter in die Wohnung der Nutzer vordringen. Nachdem der Versuch gescheitert ist, ein Smartphone zu etablieren, wollen sie diesmal unbedingt dabei sein. Sie stellen ein Gerät nach dem anderen vor und probieren einfach aus, welche ankommen.

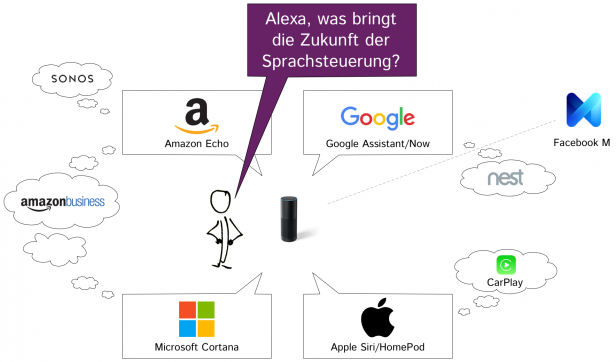

Dabei ist die Konkurrenz gewaltig. Wichtigste Vereine und Spieler sind aus meiner Sicht:

- Amazon: Alexa/Echo

- Apple: Siri/HomePod

- Microsoft: Cortana

- Google: Home

- Facebook: M

Und viele andere mischen auch mit – es bleibt abzuwarten, ob wir in den nächsten Monaten nicht noch andere Unternehmen ganz nach vorn sprinten sehen. Das könnten alte Bekannte sein wie IBM oder Telekommunikationsanbieter. Oder auch Autohersteller, Game-Anbieter oder Streamingdienste. Oder kleine Startups. Lassen wir uns überraschen.

Microsoft hat übrigens eine Kooperation mit Amazon – Office-Anwendungen lassen sich via Alexa for Business mit den Echo-Geräten steuern. So könnte Microsoft doch noch aufholen, obwohl sein Assistent Cortana derzeit wenig Beachtung findet.

Außerdem kooperieren mit Alexa for Business etliche weitere B2B-Unternehmen wie Salesforce oder SAP.

Alle wollen mitspielen: Die derzeit wichtigsten Anbieter von Sprachassistenten (nur Facebook M hat derzeit noch keine Spracherkennung, lediglich Chat).

Amazons Nachteil kann auch ein Vorteil sein: Amazon hat kein eigenes Betriebssystem. Somit spielt es mit iOS- und Android-Nutzern zusammen und hat eine große Nutzerschaft. Aber natürlich gibt es auch Probleme: Eine YouTube-Anbindung für den Echo Show wünschen sich viele Nutzer – die gibt es aber derzeit nicht, weil Amazon und YouTube über Kreuz liegen.

Entscheidender als Sprache sind die Assistenten

Für die Nutzer sehr ärgerlich. Für die wird es entscheidend, wer das Rennen macht. Denn derzeit liegt der Schwerpunkt bei den Sprach-Assistenten auf der Sprache. Das Neue und Begeisternde ist die Sprachsteuerung. Aber das Revolutionäre wird der zweite Teil des Wortes sein: die Assistenten.

Denn die Sprachsteuerung ist nur eine andere, bequemere Eingabemethode. Bei den Assistenzfunktionen dagegen geht es um die Inhalte. Die Nutzer delegieren Entscheidungen an die Assistenten. Und das ist ein tiefer Einschnitt in das Nutzerverhalten und möglicherweise auch in das Konsumverhalten.

Gute Assistenten zu erstellen kostet Geld. Nutzer wollen aber am liebsten nichts zahlen. Also liefern wir uns möglicherweise auch hier denen aus, die mit den Nutzern Geld verdienen. Wo kommt das Geld her? Provisionen? Zahlen diejenigen, die auf die Plattformen gehen? Welche Interessen haben sie?

Letztlich zahlen vermutlich diejenigen, die das Geschäftsmodell der Anbieter nicht durchschauen. Die auf Punkte-Schnäppchen ansprechen und letztlich mehr kaufen, als sie sonst würden ohne Punktesammel-Karte. Die auf den 1. Eintrag der Google Trefferliste klicken, weil sie nicht wissen, dass das bezahlte Anzeigen sind (oder es ihnen egal ist). Die im Shop die „empfohlenen“ Produkte kaufen – ohne die Basis für diese Empfehlung zu hinterfragen.

Schon beim Echo Show spürt man erste Ausläufer dieser Problematik der Abhängigkeit vom Anbieter: YouTube-Filme gibt es hier nicht, weil sich die Unternehmen nicht einigen. Die Nachrichtenauswahl übernimmt Amazon – aus welcher Quelle die kommen, kann man weder herausfinden noch beeinflussen. Als Nutzer kann ich die Nachrichten, die auf dem Bildschirmschoner angezeigt werden, an oder ausschalten – mehr nicht.

Man ahnt, warum Amazon ein so rasantes Tempo vorlegt. Und auch die Preisgestaltung lässt erkennen, dass es nicht um den schnellen Gewinn geht. An sich ist der Preis für den Amazon Show z.B. nicht hoch: Für um die 200 Euro bekomme ich den besten Lautsprecher, den es derzeit von Amazon gibt (nur der Sonos klingt besser und hat auch Alexa-Integration). Mit dabei ist ein sehr nützlicher 7-Zoll-Touchscreen (ca. 18 cm), der sich sehen lassen kann. Auf dem Frühstückstisch macht er keine schlechte Figur.

Wer als Anbieter einmal in der Küche, im Schlafzimmer ist, der hat gute Chancen dort zu bleiben. Nutzer wollen nicht die Eigenheiten von jedem neuen Assistenten lernen. Haben sie sich mit einem angefreundet, bleiben sie lieber bei dem. Das gilt für einzelne Apps, Skills wie auch für Geräte.

Sie wollen nicht ständig irgendwelche Skills aktivieren. Und wenn sie es doch tun, wollen sie nicht darüber nachdenken müssen, wie der jeweilige Skill heißt, mit dem sie eine bestimmte Aufgabe erledigen können.

Wir können sehr gespannt sein, was sich auf diesem Feld in den nächsten Monaten tut. Was denken Sie, wo geht die Reise hin? Über Kommentare mir Ihrer Einschätzung würde ich mich sehr freuen.

Erst einmal danke für diese Betrachtung von mehreren Seiten. Hat mir als Nichtbesitzer von Alexa oder dergleichen einiges gebracht.

In der Frühzeit von neuen Technologien ist ja der Fehler beinahe schon gewöhnlich, die Durchsetzungskraft der Neuheit zu unterschätzen. Von daher würde ich vermuten: Wir haben noch gar nichts gesehen, die begeisternden Ideen kommen erst noch. Der zentrale Punkt scheint mir zu sein, dass die Sache noch eine ganze Drehung weiter geht, wenn auf die Sprachststeuerung KI-Fähigkeiten draufgesetzt werden.

Der andere Punkt wäre – wie jedes Mal – vom Bedarf her zu denken: Für wen hat wann und wozu Sprachsteuerung Vorteile? Ganz allgemein lässt beobachten, dass ich für Sprachsteuerung dankbar bin, wenn ich ansonsten schon anders gebunden bin, z.B. Autofahrer, die ein Telefongespräch herstellen wollen, ein Arzt bei der Operation, Leute, die gerade Zwiebeln schneiden, wenn ich im Eilschritt durch die Stadt oder den Flughafen unterwegs bin oder nicht zuletzt ältere Menschen mit Bewegungsschwierigkeiten (Remote-Befehle). Anderes Beispiel: Bei Präsentationen/Vorlesungen an der UNI ist die konventionelle Fernsteuerung schön leise und diskret, aber wie wäre es mit sprachgesteuerten Hervorhebungen in Echtzeit? Die radikal neuen Use-Cases dürften nach und nach entdeckt werden und möglicherweise auch technologisch mehrteilige Lösungen erfordern, die für Startups attraktive Chancen darstellen, vielleicht sogar für Patente.

Ferner glaube ich nicht an Verdrängung, sondern an Ergänzung – also immer mehr hybride GUIs, z.B. Tastatur plus Touchscreen plus Sprechsteuerung Plus N.N. (Augenbewegungen?, Gesten?).

Danke für den hilfreichen Kommentar!

Ein wichtiger Punkt ist die KI – mehr oder weniger intensiv setzen die Anbieter die schon ein für ihre Sprachassistenten, aber wenn die mal richtig durchstarten wird es richtig spannend, das sehe ich genauso.

Besonders gefällt mir auch das Beispiel mit der Fernbedienung. Wenn wir in fremden Besprechungsräumen Licht und Beamer mit Sprache steuern können (oder die Klimaanlage im Hotelzimmer), dann macht die Usability einen großen Schritt nach vorn…