Konzeption von Voice User Interfaces – Trends, Tipps & Tools

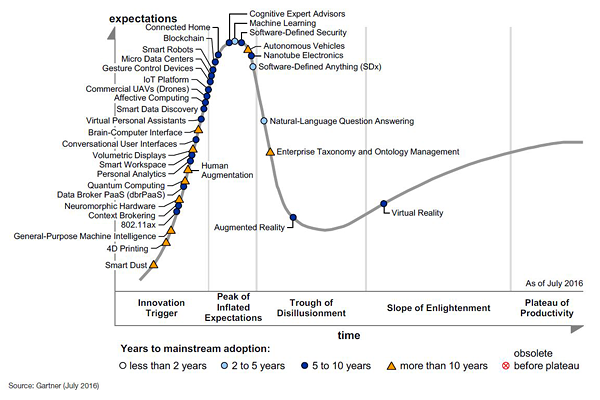

Sprach-gesteuerte Anwendungen sind in aller Munde. Viele Experten prophezeihen, dass die Voice User Interfaces grafische Interfaces komplett ablösen werden. Auch das Beratungsunternehmen Gartner siedeln sie noch am Anfang ihres Hype Cycles (Stand Juli 2016) an. Sie müssen die Spitze der überhöhten Erwartungen erst noch bewältigen, bevor sie dann – schätzungsweise in 5 bis 10 Jahren – in der breiten Masse ankommen und entsprechend ausgereift sind.

Gartner’s Hype Cycle zeigt, dass Conversational Voice Interfaces noch am Anfang stehen und nicht über die Spitze der überhöhten Erwartungen drüber ist. Erst in 5 bis 10 Jahren werden diese in der breiten Masse ankommen, wird geschätzt.

Bereits für 2020 erwartet das Beratungsunternehmen Gartner, dass 30% aller webbasierten Sitzungen ohne Screen stattfinden werden. Auch Chatbots und sonstigen Sprachassistenten sprechen sie eine erfolgreiche Zukunft aus: Über 85% aller Interaktionen mit dem Kunden sollen laut Gartner dann ohne Menschen erfolgen. Und laut ComScore werden bis dahin die Hälfte der Suchanfragen mit Sprache ausgeführt.

Wenn man sich die Qualität der meisten aktuell verfügbaren Skills und Anwendungen ansieht, ist das schwer vorstellbar. Wie mein Kollege Jens Jacobsen in seinem Beitrag zu Fehlern in der Konzeption von Sprachassistenten bereits eindrücklich beschrieben hat, sind zahlreiche Skills zum Scheitern verurteilt. Etwa, weil nicht alle Eventualitäten berücksichtigt wurden? Weil nicht bedacht wurde, dass der Nutzer mit einer unsichtbaren Informationsarchitektur klarkommen muss? Dass er ohne Display trotzdem wissen muss, wo im System er sich gerade befindet, wie er möglicherweise zurückkommt und welche Befehle er überhaupt ausführen kann? Kein Wunder, dass daher meist nur einfache, klar abgegrenzte Anwendungsfälle funktionieren und genutzt werden, wie wir auch in unserer Studie zu Nutzungskontexten von Sprachassistenten herausgefunden haben.

Aller Anfang ist schwer

Das mag auch an einem der grundlegenden Usability-Heuristiken Recognition rather than recall liegen. An den für eine fehlerfreie, sprachgesteuerte Anwendung notwendigen Technologien (insbesondere Spracherkennung, Natural Language Processing und Artificial Intelligence) kann es nur bedingt scheitern. Probleme, die darauf zurückzuführen sind, werden perspektivisch mit Ausreifen der Technologien verschwinden. Google-CEO Sundar Pichai selbst berichtete auf der diesjährigen Google I/O, dass das Unternehmen die Fehlerquote bei der Erkennung von Sprache auf 4,9 Prozent senken konnte. Letztes Jahr im Sommer lag diese noch bei 8,5 Prozent, vor drei Jahren noch bei 23 Prozent.

Liegt es also nicht eher daran, dass die Konzeption von sprachgesteuerten Anwendungen so deutlich anders ist als die Konzeption grafischer User Interfaces und hier erst Erfahrungswerte gesammelt warden müssen? Sicherlich bleibt vieles gleich, nicht zuletzt die nutzerzentrierte Herangehensweise, die immer zugrunde liegen sollte. Sie ist umso wichtiger bei der Konzeption sprachgesteuerter Anwendungen, weil die meisten noch nicht auf umfangreiche Analytics-Zahlen zurückgreifen können, um zu analysieren, wie Nutzer handeln bzw. kommunizieren.

Doch statt Scribbles bei grafischen UIs tastet man sich eher über Flowcharts an die sprachgesteuerten Anwendungen. Statt Wireframes zu erstellen, schreibt man Skripte. Das Prototyping sieht dann komplett anders aus. Schließlich geht es darum, Computern die Kunst beizubringen, eine Konversation mit einem Menschen zu führen. Folgende Überlegungen sollten Sie daher im Zuge des Konzipierens von sprachgesteuerten Anwendungen mit einbeziehen:

-

Machen Sie sich Gedanken zur Persona Ihres Skills

Personas können nicht nur für Nutzertypen gestaltet werden, sondern auch für Anwendungen. Bei sprachgesteuerten Anwendungen achten Nutzer mangels eines visuellen Feedbacks oder Interfaces umso stärker auf Aspekte wie die Stimme, Wortwahl, Satzlänge, Syntax und das Antwortverhalten des Sprachassistenten. Für sie steht hinter dem Sprachassistenten immer eine Person.

Voice User Interfaces haben kein oder nur ein minimalistisches visuelles Interface.

Umso wichtiger für eine gelungenes Nutzererlebnis ist es, dass der Nutzer das Gefühl hat, durchgängig mit ein und derselben Person zu sprechen. Sie sollten sich also bei der Entwicklung des Sprachinterfaces Gedanken dazu machen, wie diese Person aussieht. Ist sie männlich/weiblich (Geschlecht), jung oder eher alt (Alter), wie drückt sie sich aus (Bildungsgrad) und wie reagiert sie auf die Spracheingaben (Charaktertyp)? Stellen Sie sich vor, Sie möchten über das Sprachinterface eine Banküberweisung erledigen. Möchten Ihre Nutzer dann eher ein seriöses Gegenüber, höflich und zuvorkommend, mittleren Alters und möglicherweise männlich?

-

Erstellen Sie sich Flowdiagramme zu den geplanten Funktionalitäten Ihres Skills

Bevor Sie sich ans Skript schreiben machen, sollten Sie die wesentlichen Aktionsschritte für die geplante Aktivität, Interaktion oder Transaktion Ihres Skills identifizieren. Nehmen wir das Beispiel “Bankgeschäfte erledigen”: Neben einer Banküberweisung könnten Interaktionen wie die Abfrage des Kontostands oder Vormerkungen auf der Kreditkarte interessant sein. Auch nächste Zahlungstermine (z.B. aus Daueraufträgen) könnten spannend sein. Sammeln Sie diese so genannten Intents, also das Vorhaben oder eine Zielsetzung des Nutzers.

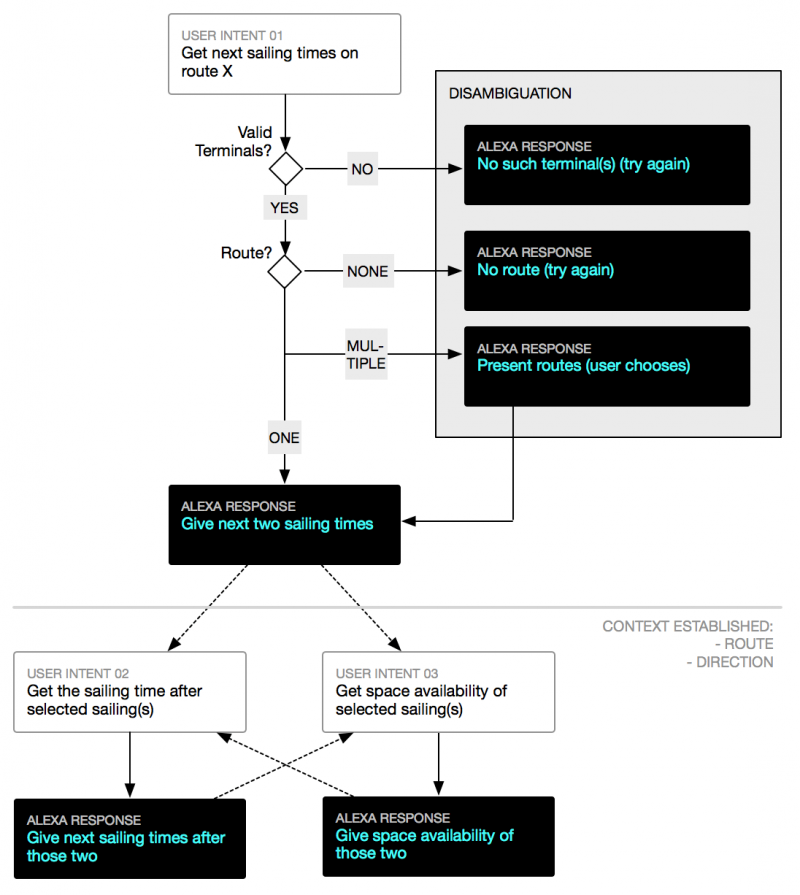

Sind die Interaktionen komplexer (z.B. eine Buchung oder eine Bestellung nach vorheriger Auswahl), dann erstellen Sie sich am besten kleine Flowdiagramme (Flow Maps), mithilfe derer Sie den Ablauf der Konversation in grobe Schritte einteilen. Es geht darum, zu erkennen, welche Informationen oder Daten der Skill vom Nutzer braucht, um bestimmte Handlungen ausführen zu können. Außerdem helfen Ihnen die Flowdiagramme dabei, Stellen zu identifizieren, bei denen es Ausnahmen gibt oder verschiedene Möglichkeiten. Kommunikation ist nicht linear. Sie kann verschiedene Wege einschlagen. Sich daran heranzutasten, dabei helfen diese Diagramme – wie im folgenden Beispiel eines Alexa Skills für einen Fähr-Fahrplan:

-

Entwickeln Sie ein Skript für Ihren Skill

Auf dieser Basis können Sie sich dann daran machen, Dialoge für diese Intents und die entsprechenden Antworten des Sprachassistenten zu schreiben. Natürlich gibt es unterschiedliche Wege, zu kommunizieren. Genau so, wie Nutzer auf Websites oder Apps auch unterschiedliche Navigationswege einschlagen (z.B. über die Menüstruktur, Suchfunktion, Teaser auf der Startseite), werden sie auch unterschiedliche Spracheingaben tätigen. Darüber sollten Sie sich später auch noch Gedanken machen. Starten Sie zunächst mit einer Möglichkeit und orientieren Sie sich dabei an Ihrem Flowdiagramm.

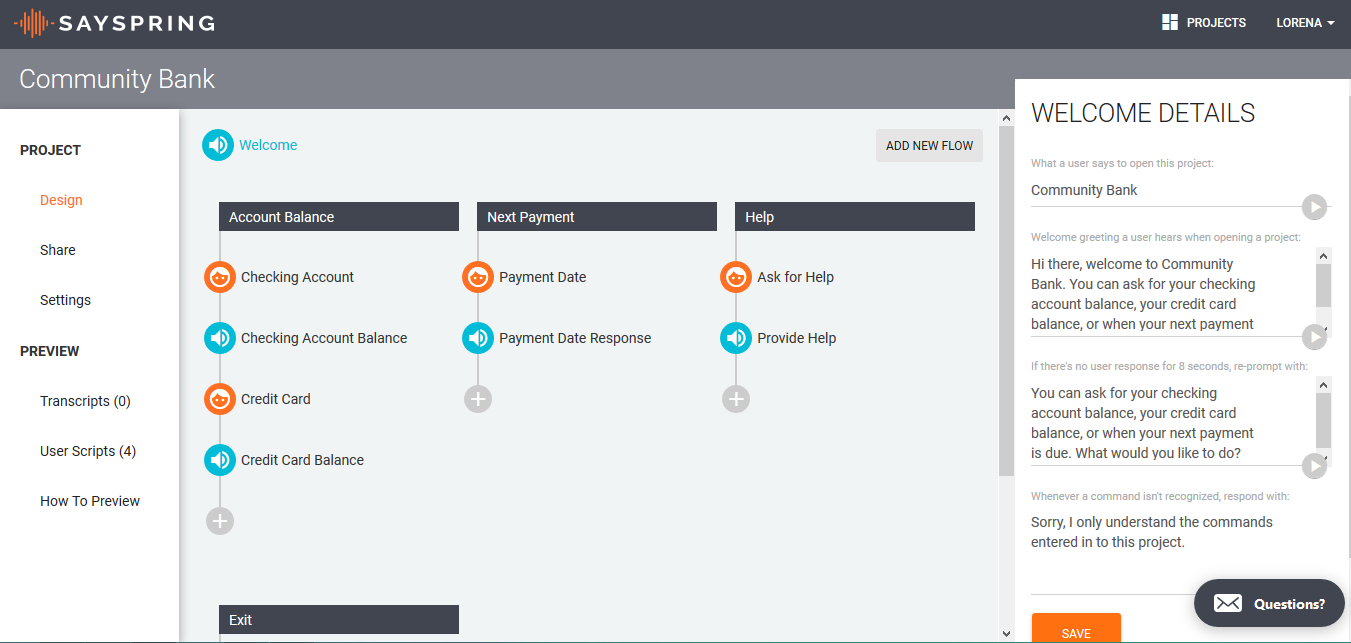

Es gibt auch Tools, die Ihnen bei der Sammlung und Strukturierung der Flows, Intents sowie der entsprechenden Dialoge helfen. Wie beispielsweise Sayspring, eine Design- & Prototyping-Software für Voice User Interfaces. Leider ist sie aktuell nur für UK und US verfügbar, aber der Blick in das Testprojekt, ein Skill für eine Bank, lohnt und lässt auf eine Ausweitung für Deutschland hoffen. Die Software unterstützt dabei, die einzelnen Intents zu strukturieren und diese dann auszugestalten. Im abgebildeten Beispiel sehen Sie im Contentbereich mittig mehrere Flows mit inhaltlich dazugehörigen Intents. Nach Auswahl eines Intents erscheint rechts die Eingabemaske für die Dialoge.

Die Software SaySpring unterstützt dabei, die einzelnen Intents zu strukturieren und diese dann auszugestalten.

-

Bedenken Sie Ausnahmen, Varianten und unterschiedliche Ausdrucksformen

Worauf Menschen auf natürliche Art und Weise reagieren in einer Konversation, müssen Sie Sprachassistenten nach und nach beibringen. Alle Ausnahmefälle, Störungen und Eventualitäten sollten idealerweise bedacht sein. Und vor allem auch die Unterschiede in der Art und Weise, wie Nutzer sprechen, wie Sie formulieren oder Wörter wählen, sind eine Herausforderung für die Konzeption eines Skills, das den Nutzern einen Mehrwert bringt. Selten ist das auf Anhieb zu schaffen. Aber umso lohnenswerter, wenn Sie sich die Zeit nehmen, diese Fälle zu betrachten.

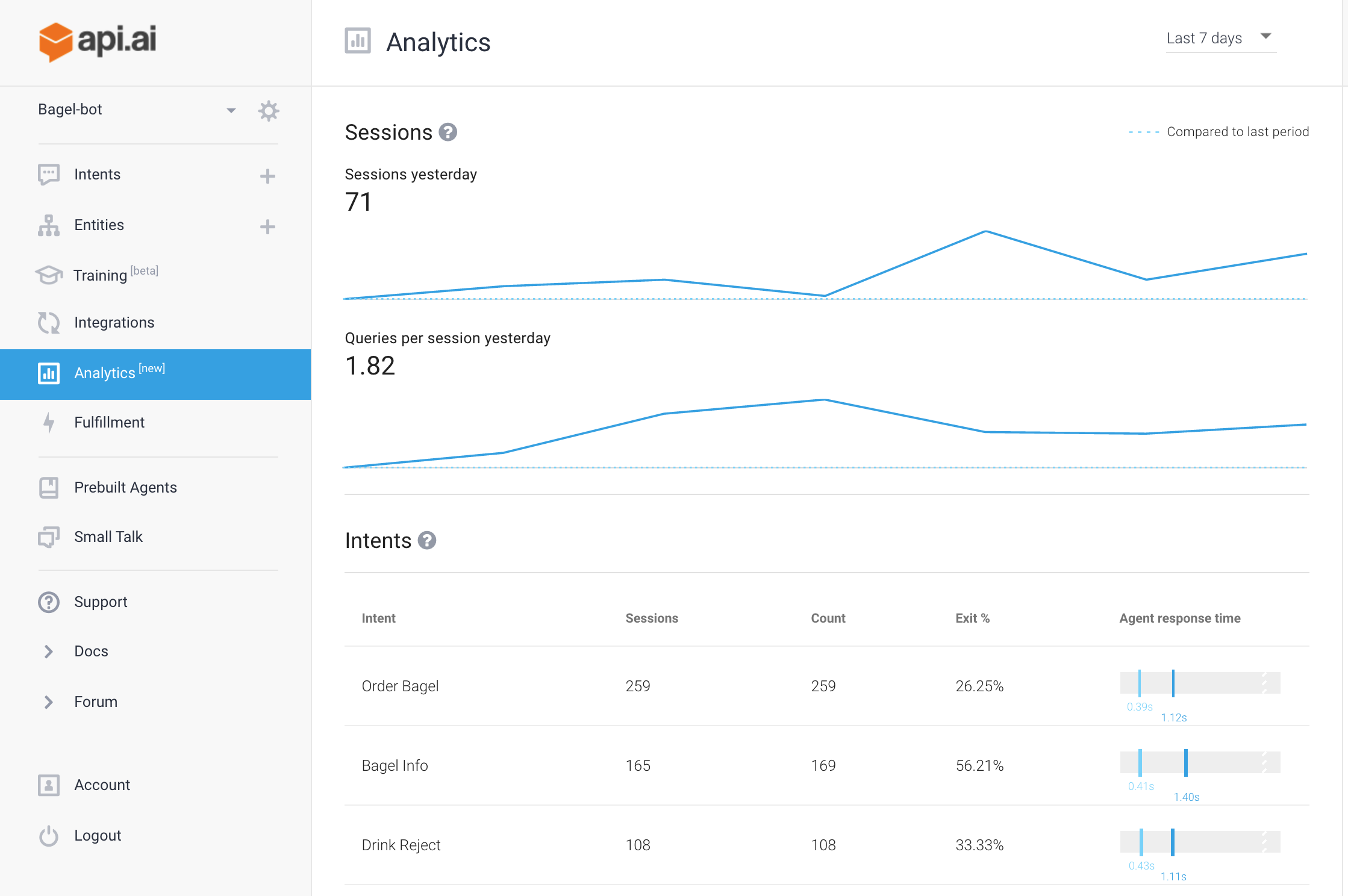

In diesem Zusammenhang lohnt sich, das Video zur Präsentation In conversations, there are no „errors“ von der diesjährigen Google I/O 2017. Dort wird unter anderem gezeigt, in welchen Situationen Sie dem Nutzer helfen können, in die Interaktion (wieder) einzusteigen und wie Sie den jeweiligen Nutzungskontext berücksichtigen. Sie erhalten zudem einen kleinen Einblick in Google’s Prototyping- und Entwicklungsplattform für Anwendungen für den Google Assistent: api.ai.

-

Testen Sie und lernen Sie dazu

Bevor Sie Ihren Skill launchen, sollten Sie diesen selbstverständlich testen. Prototyping-Tools wie die zuvor genannten (z.B. api.ai, SaySpring) ermöglicht es Ihnen, Ihr Konzept zu testen. Sie können aber auch früher im Entwicklungsprozess auf Basis einfacher Skripte testen. Hierfür bietet sich die “Wizard of Oz”-Methode an. Statt eines echten Devices oder Prototypen gibt eine Person mithilfe vorbereiteter Textbausteine aus dem Skript die Antworten, die der Sprachassistent ansonsten gegeben hätte. Mein Kollege Xaver Bodendörfer berichtete bereits Anfang des Jahres darüber, wie man Usability-Test mit Sprachassistenten durchführt und was dabei zu berücksichtigen ist.

Seit Kurzem ist in Google’s api.ai auch ein Analytics-Bereich integriert, aus dem Sie nach Launch Ihres Skills laufend Nutzungsdaten ziehen können. Es werden unter anderem Daten bereitgestellt zu den beliebtesten Intents, zu Ausstiegen und Antwortzeiten des Sprachassistenten. Eine gute Basis für die stetige Weiterentwicklung.

Wie sind Ihre Erfahrungen mit der Konzeption von sprachgesteuerten Anwendungen? Kennen Sie weitere Tools zum Gestalten und Prototypen von Voice User Interfaces? Berichten Sie gerne. Wir freuen uns auf Ihre Kommentare!

Pingback: Emerald - Prototyping für Conversational User Interfaces? - Usabilityblog.de

Pingback: Amazon Alexa Skill Blueprints: Skill Entwicklung für jedermann? - Usabilityblog.de