Prototyping: Wie muss ein Klickdummy aussehen?

Neue Funktionen auf Websites und Software sollten vor der Umsetzung mit den späteren Nutzern getestet werden, dafür gibt es viele gute Argumente.

Aber wie muss dieser Dummy eigentlich aussehen? Sollte er dem späteren Layout möglichst nah kommen, sollten also Bilder, Farben und echte Inhalte verwendet werden, oder spielt das für die Beurteilung einer Funktion kaum eine Rolle?

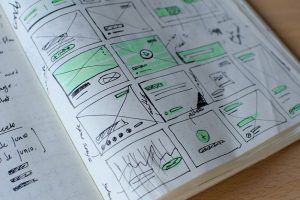

Zusammen mit der eResult GmbH habe ich versucht, mich mit dieser Frage mit einem kleinen Experiment zu nähern und dazu zwei Klickdummys erstellt. Beide beinhalteten die gleichen Funktionen und Inhalte – und in beide waren die gleichen Usability-Hürden eingebaut. Allerdings wurden in den einen Dummy Gestaltungselemente wie Bilder und Farben integriert, der andere bestand weitgehend aus schwarzen Linien auf weißem Hintergrund.

Beide Klickdummys haben wir mit ein paar Nutzern getestet, wobei jede nur eine Variante zu sehen bekommen hat.

Von den Ergebnissen dieser Tests waren wir selbst überrascht:

Aussagen und Verhalten der Testpersonen waren für beide Fälle nahezu gleich. Die Funktionen konnten gleich gut genutzt werden, die Usabilityprobleme wurden ebenfalls in beiden Fällen aufgedeckt.

Lediglich hinsichtlich der Textinhalte und Benennungen konnten wir für den Dummy „ohne Schminke“ etwas mehr Kritik aufnehmen, was darauf hindeutet, dass sich die Testpersonen in dieser Variante stärker auf solche Aspekte konzentriert haben.

Hatten wir nun zufällig Testpersonen mit einem besonders hohen Abstraktionsvermögen, oder spielt die Gestaltung eines Dummys tatsächlich keine Rolle für die Beurteilung einer Funktion? Wie sind eure Erfahrungen?

Je näher am Original, desto besser – das ist meine Erfahrung. Wir versuchen immer recht früh auch das Design mit in Clickdummys reinzunehmen, denn je besser die Vorstellung der Probanden über das Endprodukt, desto realistischer sind die Aussagen. Das Design soll die Funktionalität schließlich unterstützen. Die Frage ist eher, ob man mit dem Testing auf ein Design warten soll, wenn es noch nicht vorliegt. Das wiederum hängt von der gesamten Projektplanung ab. Wie viele Tests sind insgesamt geplant und zu welchen Zeitpunkten. Eine pauschale Antwort gibt es also kaum.

Das ist in jedem Fall sehr interessant, da ein kurzer Funktionstest vor finalem Design durchgeführt werden kann. Wäre toll, wenn wir genauere Testergebnisse sehen könnten.

Kommt darauf an. Wenn ich valide Aussagen zur Funktionalität haben will (wird das Konzept der Suche verstanden? Stimmt die Info-Architektur? Etc.), könnten Testergebnisse durch ein zu stark ausgestaltetes Layout verfälscht werden. Ich weiß dann am Ende nicht mehr, ob eine Funktion oder nur ein Designdetail verbesserungsbedürftig ist. Besser ist es, hier immer nur einen Bereich pro Test zu untersuchen: Erst die Info-Architektur (Card Sorting), dann die Funktionalität (Prototyp/Klickdummy), dann das Layout (Beta o. Ä.).

Das stimmt doch mit meiner o.g. Aussage überein: wenn man im Projekt Zeit und Geld für 3 Test hat ist das o.k. aber nicht jedes Projekt gibt das her (auch wenn ich persönlich es für notwendig halte). Im Übrigen sollte man durch die Interviews mit Probanden durchaus herausfinden können, ob’s am Design oder an der Funktin selbst liegt.

Nach meiner Erfahrung kann man von den Testpersonen leider nicht immer erwarten, dass Funktion und Design getrennt voneinander beurteilt werden. Wenn auch unbewusst: das Layout beeinflusst das „Erleben“ einer Funktion immer in irgendeiner Form denke ich. Zudem sollten Aussagen zum Design mit einer kleinen Stichprobe, wie sie beim Prototyping üblich ist, nicht überbewertet werden. Hier kann man nur quantitativ verlässliche Antworten erhalten.

Vielen Dank für Eure Anmerkungen.

Ich interpretiere die Ergebnisse auch in diese Richtung: Wenn man eine neue Funktion entwickelt, ist ein Test schon vor der Designentwicklung möglich und sehr sinnvoll. Zumal sich die dort aufgezeigten Schwachpunkte eines Konzepts sicher auf das Interaktionskonzept beziehen und Kritik am Grundkonzept in diesem Stadium noch leichter fällt. Liegt allerdings das Design schon vor, kann man es meiner Meinung nach auch für einen Klickdummy schon verwenden, muss dann aber mit mehr Detailproblemen rechnen.

Sprich: eigentlich ist es im komplett „designten“ Stadium für einen Test der grundlegenden Interaktion schon etwas spät, aber natürlich besser, als gar nicht zu testen.

Bemerkenswert fand ich in meinem Experiment übrigens auch die Schilderung des ersten Eindrucks und die Beobachtung der Reaktionen bei ber Konfrontation mit dem Klickdummy „ohne Schminke“. Kaum eine Testperson zeigte sich überrascht, fast alle abstrahierten die gezeigte Seite und bezeichneten sie als „bekannt“ und „gewohnten Aufbau für eine Detailseite in einem Onlineshop“. Das hätte ich nicht erwartet, zeigt aber einmal mehr, dass man ruhig von etwas Abstraktionsvermögen ausgehen kann.

Das erinnert mich an die erten „Click-Dummies“, die wir in den 90ern gebaut hatten: Einfach die JPGs der gestalteten Screenshots mit einer Clickmap (HTML)hinterlegt, um Clickstreams zu prüfen, Info-design zu testen.

Bis hin zu „HTMLisierten“ Paperprototypen, die, das Design, so gut es geht, verheimlichten…

… ups… da war der Kommentar schon weg, bevor ich fertig getippt hatte… was ich noch sagen wollte: Die Ausstattung des Clickdummies hängt unmittelbar vom zu prüfenden Gegenstand ab. Wenn ich bspw. eine Site überprüfen muss, die hauptsächlich von Content getragen wird, muss ich diese nat. mit Content ausstatten. Wenn es um Funktionen geht, dann kann ich vielleicht schon eher mit „Blindtexten“ arbeiten, bspw. in einer Suche oder Sortierung…

Die unterschiedliche Gestaltung von Prototypen scheint tatsächlich nicht die Rolle zu spielen, die ihr manchmal zugemessen wird. Davon berichteten auch Kollegen von der Uni Osnabrück bei der M&C 2009: „Zur Gestaltung und Effektivität von Prototypen im Usability-Engineering“. Die Autoren Kai-Christoph Hamborg, André Klassen und Malte Volger bekamen mit diesem Thema den MCI best paper award.