Sprachassistenten – typische Fehler in der Konzeption & wie man sie vermeidet

Was brauchen Nutzer? Um diese Frage dreht sich die ganze Produktentwicklung. Und mit ganz, ganz wenigen Ausnahmen steht diese Frage am Anfang jeder erfolgreichen Anwendung.

Und doch scheint mir, wird diese Frage aktuell sträflich vernachlässigt bei der aktuellen Konzeption von Sprachassistenten. Nach meinem Eindruck haben viele Unternehmen das Gefühl, dass auf diesem Gebiet etwas passiert, was ganz wichtig wird. Es ist die Rede davon, dass grafische Nutzeroberflächen nach und nach verschwinden. Wer jetzt mit dabei ist, der hat die Chance, langfristig relevant zu bleiben, wenn Nutzer in Zukunft Anwendungen nur noch mit Sprachbefehlen steuern. Ob das so kommt, sei mal dahingestellt.

Anknüpfend an den Beitrag meines Kollegen Xaver Bodendörfer (Usability-Tests mit Sprachsteuerungen/-assistenten) meine Eindrücke aus der Praxis, nachdem ich in den letzten Wochen knapp 200 Aufzeichnungen der Interaktion von Probanden mit Amazon Echo gehört habe.

Mein Fazit: Vielfach werden offenbar Systeme entwickelt, die irgendwie zum eigenen Angebot passen. Es steht die Frage am Anfang: Was können wir anbieten? Welche Daten haben wir, für welche Aufgaben nutzen die Menschen unsere Anwendungen derzeit, was erwarten sie sonst von uns?

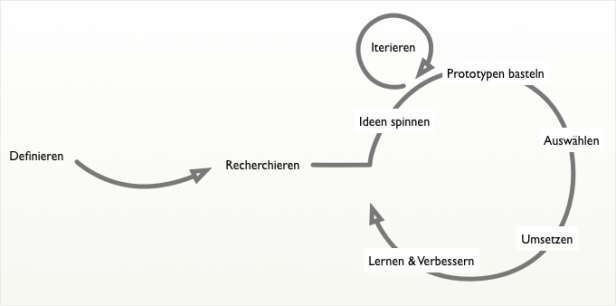

Das hat wenig mit nutzerzentrierter Entwicklung zu tun, selbst wenn man dann in den nächsten Schritten vorbildlich Nutzertests durchführt.

Ist die Grundidee nichts, helfen auch Nutzertests nur wenig – sofern man nicht bereit ist, auch die Grundidee auf den Prüfstand zu stellen und sie nochmal zu hinterfragen. Und im schlimmsten Fall nochmal ganz von vorn anzufangen. Also bei der Ideenfindung, der Ideation.

Nielsens Aprilscherz dieses Jahr hatte genau das zum Thema: Er machte sich lustig über alle, die der Ideenfindung zu wenig Bedeutung beimessen:

Cool UX-ers pick the first idea, and run with it.

(Coole UXler nehmen die erste Idee und ziehen sie durch.)

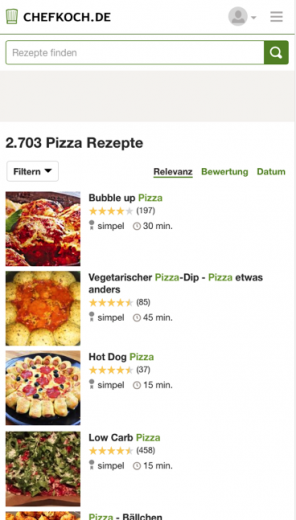

Status quo: Was wird angeboten

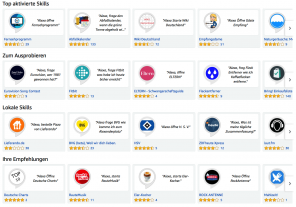

So absurd ist der Scherz gar nicht. Wenn man sich einmal ansieht, welche Skills es derzeit für Amazons Echo/Alexa gibt, hat man den Eindruck, viele seien genau dem „Tipp“ gefolgt, die erstbeste Idee umzusetzen. Dementsprechend schlecht sind auch die Bewertungen. Knapp 800 Skills gibt es zum Download, derzeit sind die Kategorien:

- Bildung und Nachschlagewerke

- Dienstprogramme

- Essen & Trinken

- Film & Fernsehen

- Gesundheit & Fitness

- Lifestyle

- Lokales

- Musik & Audio

- Nachrichten

- Neuheiten & Humor

- Produktivität

- Reise & Transport

- Shopping

- Smart Home

- Soziale Netzwerke

- Spiele, Quiz & Zubehör

- Sport

- Vernetztes Auto

- Wetter

- Wirtschaft & Finanzen

Deren Bewertungen sind aktuell:

- 254 haben 4 oder 5 Sterne

- 190 haben 3 Sterne

- 124 haben 2 Sterne

- 117 haben 1 Stern

Dabei fällt auf, dass die Skills bekannter Unternehmen bzw. Marken teilweise sehr schlecht bewertet sind. Und dass die Skills, die sich auf eine oder wenige Aufgaben konzentrieren, meist eine deutlich bessere Bewertung haben. Das sollte zu denken geben.

Ideation-Ansatz: Was können wir mit Sprachsteuerung überhaupt tun?

Aber wie kommt man nun auf Ideen für den Einsatz von Sprachsteuerung, der funktioniert?

Der Kardinalfehler ist , sich darauf zu konzentrieren, was Nutzer gern tun möchten mit der Sprachsteuerung. Ein Fehler ist das vor allem aus zwei Gründen:

- Nutzer wissen nicht, was sie wollen.

- Nutzer wollen Dinge, die unmöglich sind.

Gehe ich die Recherchephase (User Research) falsch an, bekomme ich jede Menge Meinungen. Ich erfahre, was Nutzer meinen zu wollen. Sie erzählen viel und gern darüber, was sie sich wünschen, was sie nutzen würden. Aber in der Praxis sieht das dann oft ganz anders aus. Daher sind Methoden wie Ethnografische Studien oder Vor-Ort-Interviews (Contextual Inquiry) so wertvoll, um die wirklichen Probleme und Nutzungssituationen kennen zu lernen. Von diesen aus kann man dann in die Ideenentwicklung einsteigen.

Der zweite Punkt, dass die Nutzer Unmögliches wollen, ist dann etwas später im Prozess relevant. Natürlich hätte ich gern einen Sprachassistenten, der aus dem Zusammenhang heraus weiß, was ich meine. Der mich trotz Grammatikfehlern, Dialekt oder unklaren Formulierungen versteht. Und der E-Mails schreibt, Telefonanrufe führt und Bestellungen aufgibt, ohne dass ich Sorge haben muss, dass da gerade etwas gewaltig schief läuft.

Einerseits will ich mich bei der Ideenentwicklung nicht durch technische Vorgaben einschränken lassen. Sobald es aber einen Schritt in Richtung Umsetzung geht, spielt die Technik eine Rolle. Aber es ist nicht nur die Technik, die mir bei manchen Konzepten einen Strich durch die Rechnung macht.

Vielfach liegt es einfach in der Natur der Sache, dass Manches mit Sprachsteuerung nicht gut funktioniert. Unsere Konzeption kommt noch sehr aus dem Arbeiten mit dem Bildschirm – selbst ein winziges Handy-Display hat hier Vorteile gegenüber der besten denkbaren Sprachsteuerung. Wir berücksichtigen zu wenig, dass beide Ausgabemedien fundamental anders funktionieren.

Was nicht funktioniert

Auf einem Display habe ich eine Liste schnell überflogen und erfasst – da liest Alexa gerade noch den 1. Eintrag vor.

Der wichtigste Punkt aus meiner Sicht: Viele Apps scheitern, weil sie lange Listen ausgeben müssen. Für Listen ist die Sprachausgabe denkbar schlecht geeignet. Hier ist jedes Display mit mehr als ein paar Zeilen klar im Vorteil.

Eine Liste muss vorgelesen werden. Das passiert praktisch immer in einer festen Geschwindigkeit – manchen Nutzer ist sie zu langsam, anderen zu schnell. Und alle müssen sich konzentrieren und zuhören. Und vor allem müssen sie warten, bis die Liste zu Ende vorgelesen ist. Mehr als ein paar Listenpunkte kann sich kein Mensch merken – daher ist der Kompromiss, den die meisten Anwendungen gehen, der: Sie lesen die ersten zwei, drei oder vier Einträge vor. Dann fragen sie beim Nutzer nach, ob er etwas zu einem dieser Treffer wissen will oder ob die Liste weiter vorgelesen werden soll.

Bei 10 oder mehr Treffern wird das mühselig und zeitraubend. Eine Liste auf einem Bildschirm habe ich in Sekunden überflogen und habe zum einen einen Überblick über die Treffer und mir schnell einen ausgesucht.

Ebenfalls ein Problem in der Natur der Sache ist, dass die Detailtiefe der Antworten oft schwer richtig zu treffen ist. Was in der einen Nutzungssituation zu viel Information ist, ist in der anderen zu wenig. Und woher weiß der Nutzer, dass es noch Detailinfos gibt? Meist sagt man es ihm und nennt die Schlüsselwörter, mit denen er sie jeweils abrufen kann. Denn merken kann man sich diese nicht, also kommt nach jedem Paket mit Treffern wieder die Aufforderung, Details mit Begriff A, B oder C abzurufen.

Das ist sinnvoll, denn anders als auf einem Bildschirm sieht der Nutzer ja keine Buttons, mit denen er das tun könnte. Aber dennoch führen diese Wiederholungen leicht zu Frustration. Ein Beispiel aus einem Test: Der Skill sagte stets am Ende jedes Treffer-Pakets:

Willst du mehr Infos zu den Treffern? Dann sage eins, zwei oder drei. Oder sage „Suche Neuerscheinungen“ für eine neue Suche.

Das hörten die Probanden dann teilweise fünf, sechs und mehr mal hintereinander, während sie sich durch die Listen arbeiteten und die vorlesen ließen. Hierbei gab es oft Probleme, und so stieg die Frustration laufend. Der monotone Hinweis, nach „Neuerscheinungen“ zu suchen brachte dann bei einem Nutzer das Faß zum Überlaufen:

Alexa: […] Willst du Autoreninformationen? Dann sage eins für Treffer eins. Oder sage „Suche Neuerscheinungen“ für eine neue Suche.

Nutzer: Autoreninformationen.

Alexa: Willst du Autoreninformationen? Dann sage eins für Treffer eins. Oder sage „Suche Neuerscheinungen“ für eine neue Suche.

Nutzer: Eins Autoreninformationen.

Alexa: Leider konnte ich dazu nichts finden. Sage „Suche Neuerscheinungen“ für eine neue Suche.

Nutzer (seufzt): Dann eben Neuerscheinungen.

Der wiederholte Hinweis war für den Nutzer erstens in seiner Situation nicht hilfreich – er wollte etwas anderes. Außerdem hatte er in dieser Situation längst verstanden, wie er eine neue Suche startet. Hier kann man natürlich im Detail optimieren durch Variation der Hinweistexte, durch Spielen mit der Länge und durch bessere Kontext-Analyse.

Aber das Problem in der Sache bleibt: Längere Listen sind schwierig. Und das fehlende Wissen um die Steuermöglichkeiten auch.

Und manche Sachen klingen super – und sind es auch, wenn sie funktionieren. Wenn sie aber nicht funktionieren, dann bringt es nichts, sie umzusetzen – sie frustrieren dann nur.

Vielfach ist die Spracherkennung einfach noch nicht gut genug. Die Suche nach Eigennamen z.B. ist sehr schwierig, wenn der Pool an möglichen Namen größer wird. Stehen im eigenen Adressbuch nur eine Handvoll Namen, ist es kein Problem. Aber im Telefonbuch einer Großstadt wird es komplex. Müller und Meier werden noch gut erkannt, aber wer Bekannte wie Müller-Lügenscheidt hat, wird auf Probleme stoßen. Und Wiclitzky oder Suwanlidulah gehen gar nicht.

Was gut funktioniert

Am besten für die Sprachsteuerung eigenen sich derzeit so genannte one-shots. Also Aufgaben, die mit einer Anweisung erledigt sind.

Alexa, setze Milch auf die Einkaufsliste.

Alexa, Timer 5 Minuten.

Alexa, schalt das Licht im Wohnzimmer aus.

Auf solche Aufgaben muss Alexa nur noch Vollzug melden. Ebenso gehen Sachen gut, die eine Aufgabe starten:

Alexa, spiel Musik.

Alexa, wer ist Jakob Nielsen?

Alexa, wie hoch ist die Zugspitze?

Je weniger der Nutzer also auswählen muss, desto besser. Denn zum Auswählen muss sich der Nutzer entweder die Steuerwörter merken. Oder wir müssen sie ihm nochmal sagen. Das ist nicht nur umständlich, es erfordert mehrere Schritte und dauert dadurch zum einen länger. Zum anderen gibt es mehr Möglichkeiten zu Missverständnissen oder Fehlbedienungen.

Ebenfalls ungünstig sind Aufgaben, die nur gelegentlich erledigt werden müssen. Denn für die muss sich der Nutzer erstmal überhaupt merken, dass er sie mit dem Sprachassistenten tun kann. Dann muss er in der entsprechenden Situation auch daran denken. Und schließlich muss ihm einfallen, wie das Schlüsselwort dafür ist.

Tipp: unterschiedliche Nutzerfähigkeiten berücksichtigen

Bei der Auswertung der Nutzertests fühlte ich mich ein bisschen zurückversetzt in die Zeit, in der wir Probanden noch gefragt haben, wie oft sie einen PC verwenden und ob sie privat einen haben. Denn wir sehen einen großen Unterschied in den Fertigkeiten im Umgang mit Sprachsteuerungen. Manche Probanden sind sehr professionell, sprechen langsam und deutlich und verwenden fast nur die Schlüsselwörter. Stoßen sie auf Probleme, versuchen sie es mit anderen Formulierungen und sie sind oft sehr zufrieden mit dem System.

Auf der anderen Seite gibt es Nutzer, die erwarten einerseits zu viel vom System und sprechen mit diesem wie mit einem Menschen. Stoßen sie auf Schwierigkeiten, wiederholen sie andererseits lediglich mehrfach, was sie gesagt haben und probieren keine alternativen Ansätze aus, um zum Ziel zu kommen. Oft sind solche Nutzer am Ende unzufrieden.

Bei der Beurteilungen der Skills auf Amazon sieht man übrigens ein ganz ähnliches Bild: Manche Rezensenten sind ganz begeistert, andere vergeben nur einen Stern.

Bei der Konzeption müssen wir beide Nutzertypen berücksichtigen. Ganz wichtig ist daher auch bei Sprachsteuerungssystemen das Onboarding. Also eine Einführung in die Bedienung bei der ersten Nutzung. Diese muss im System passieren – schöne Beschreibungen der Skills im Store bringen nichts, die liest keiner (eine der weniger überraschenden Erkenntnisse aus unseren Tests).

Und diese Einführung darf nicht jedes Mal kommen, sondern muss von Besuch zu Besuch kürzer werden – im Idealfall lernt sie dazu und analysiert, was der Benutzer bisher erfolgreich tun konnte und wo es Probleme gab.

Und hier sind wir wieder beim Ausgangspunkt: Bei der Ideation. Es sind noch viele weitere gute Ideen gefragt, um Anwendungen zu konzipieren, die auch per Sprachsteuerung gut funktionieren.

Hi Jens,

sehr interessant zu lesen!

Ich bin immer dankbar für solche Artikel. Vielen Dank!

Mach weiter so.

LG

Rita